doi: 10.56294/mr202329

La importancia de la supervisión humana en el uso de ChatGPT como herramienta de apoyo en la escritura científica

The importance of human supervision in the use of ChatGPT as a support tool in scientific writing

William Castillo-González1 ![]() *

*

1Universidad de Buenos Aires. Instituto de Investigaciones en Microbiología y Parasitología Médica (UBA-CONICET). Ciudad Autónoma de Buenos Aires, Argentina.

Citar como: Castillo-González W. The importance of human supervision in the use of ChatGPT as a support tool in scientific writing. Metaverse Basic and Applied Research. 2022; 2:29. https://doi.org/10.56294/mr202329

Recibido: 17-09-2022 Revisado: 15-11-2023 Aceptado: 19-02-2023 Publicado: 20-02-2023

Editor:

Prof.

Dr. Javier González Argote ![]()

RESUMEN

Introducción: ChatGPT podría ser una herramienta de apoyo en la investigación y escritura científica, permitiendo a los investigadores centrarse en la generación de resultados y análisis de datos. Sin embargo, es importante considerar los posibles sesgos y limitaciones en la generación de texto, así como las implicaciones éticas y de calidad en la producción de conocimiento científico.

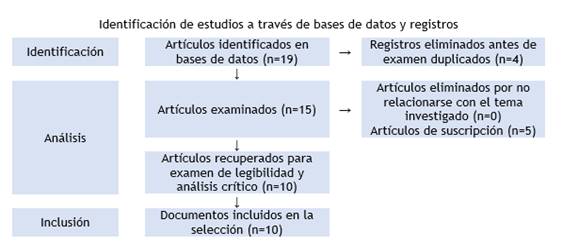

Métodos: se realizó una búsqueda bibliográfica en PubMed y Scopus con la palabra clave “ChatGPT”, estableciendo criterios de inclusión y exclusión para seleccionar 10 artículos relevantes sobre el uso de ChatGPT en investigación y escritura científica en los últimos 5 años y de acceso abierto.

Resultados: diversos autores señalan el potencial de ChatGPT como herramienta de apoyo en la investigación y escritura científica, destacando su capacidad para proporcionar comentarios y sugerencias útiles, así como su uso en la elaboración de un texto coherente y la gestión de referencias y citas; sin embargo, se advierte sobre posibles sesgos y limitaciones éticas en su uso y la necesidad de supervisión humana. La revista Nature establece principios éticos y de transparencia para su uso y recomienda la exclusión de ChatGPT como autor acreditado en un trabajo de investigación.

Conclusiones: ChatGPT es una herramienta útil en la escritura científica, pero su uso debe ser regulado para evitar la sustitución de la experiencia humana y garantizar estándares éticos y de calidad, y se debe tener precaución y supervisión humana para garantizar la exactitud de los resultados y reconocer su uso en los trabajos de investigación sin atribuirles autoría.

Palabras clave: Inteligencia Artificial; Escritura Médica; Análisis de Datos; Mejora de la productividad; Chat GPT.

ABSTRACT

Introduction: Chat GPT could be a supportive tool in scientific research and writing, allowing researchers to focus on generating results and data analysis. However, it is important to consider possible biases and limitations in text generation, as well as ethical and quality implications in scientific knowledge production.

Methods: a literature search was conducted on PubMed and Scopus with the keyword “ChatGPT,” establishing inclusion and exclusion criteria to select 10 relevant articles on the use of ChatGPT in scientific research and writing in the last 5 years and open access.

Results: various authors point out the potential of ChatGPT as a supportive tool in scientific research and writing, highlighting its ability to provide useful comments and suggestions, as well as its use in the development of coherent text and the management of references and citations. However, possible ethical biases and limitations in its use and the need for human supervision are also cautioned. The journal Nature

establishes ethical and transparency principles for its use and recommends excluding ChatGPT as an accredited author in a research work.

Conclusions: ChatGPT is a useful tool in scientific writing, but its use must be regulated to avoid the substitution of human experience and ensure ethical and quality standards, and caution and human supervision must be exercised to ensure the accuracy of results and recognize its use in research works without attributing authorship.

Keywords: Artificial Intelligence; Medical Writing; Data Analysis; Productivity Improvement; Chat GPT.

INTRODUCCIÓN

La producción y difusión de conocimiento científico es una actividad central en el desarrollo de la investigación en cualquier campo, y el área de las ciencias de la salud no es una excepción. En este contexto, la redacción de artículos científicos es una actividad clave para la difusión del conocimiento generado y la comunicación de los resultados de investigación. Sin embargo, la escritura científica es una tarea compleja que requiere habilidades específicas, conocimientos metodológicos y técnicas de redacción que no siempre son fáciles de dominar. Además, el proceso de investigación en sí mismo puede ser arduo y presentar dificultades que requieren el uso de herramientas de apoyo.(1,2,3)

En los últimos años, el avance en las tecnologías de lenguaje natural ha dado lugar al desarrollo de sistemas de generación de lenguaje que permiten la creación de texto a partir de datos de entrada. Entre ellos, destaca ChatGPT (Generative Pre-trained Transformer), un modelo de inteligencia artificial desarrollado por OpenAI que ha sido entrenado en grandes cantidades de texto y tiene la capacidad de generar texto de manera autónoma.(4)

En este contexto, se ha planteado el potencial de ChatGPT como herramienta de apoyo en la investigación y escritura científica en el área de las Ciencias de la Salud. A través de la utilización de esta herramienta, se podría facilitar la escritura de artículos científicos, permitiendo al investigador enfocar su tiempo y esfuerzo en la generación de resultados y análisis de datos, en lugar de en la redacción de un texto coherente y estructurado. Además, la utilización de ChatGPT podría mejorar la calidad de la escritura científica al proporcionar una guía y modelo para la organización de la información, así como la revisión y edición del texto.

No obstante, aunque el potencial de ChatGPT como herramienta de apoyo en la investigación y escritura científica parece evidente, es importante considerar los posibles sesgos en los datos de entrada y en la generación de texto, así como las limitaciones en cuanto a la comprensión y coherencia del texto generado.(5)

Por lo tanto, en este artículo se explorará el potencial de ChatGPT como herramienta de apoyo en la investigación y escritura científica, se discutirán sus ventajas y desventajas, y se analizarán las posibles implicaciones éticas y de calidad en la producción de conocimiento científico.

MÉTODOS

Para realizar la búsqueda bibliográfica sobre el uso de ChatGPT como herramienta de apoyo en la investigación y escritura científica, se utilizó la base de datos de PubMed y Scopus. La palabra clave utilizada fue "ChatGPT".

Se establecieron criterios de inclusión para seleccionar los estudios relevantes, tales como su enfoque en el uso de ChatGPT en la investigación y escritura científica, estar en español o inglés, haber sido publicados en los últimos cinco años y ser de acceso abierto. Por otro lado, se excluyeron aquellos estudios que se centraban en otros modelos de lenguaje o en aplicaciones fuera del ámbito científico, a fin de asegurar la relevancia y pertinencia de los estudios seleccionados para nuestro análisis.

Finalmente se incluyeron 10 artículos para el análisis, luego de aplicar criterios de selección (figura 1).

RESULTADOS Y DISCUSIÓN

El uso como herramienta de Inteligencia Artificial (IA) útil en la escritura científica de ChatGPT es mencionado por Salvagno et al.(6) Aborda que su uso debe ser regulado para evitar la sustitución de la experiencia humana, ya que puede proporcionar comentarios y sugerencias útiles y señala que es importante revisar cuidadosamente los trabajos generados para garantizar estándares éticos y de calidad.

Los autores vaticinan que, en un futuro cercano, la IA podría ser entrenada para extraer y entender toda la información relevante de los registros médicos electrónicos, analizando datos de pacientes y proporcionando recomendaciones para intervenciones médicas. La implementación de estos sistemas de AI, junto con chatbots, podría crear un sistema interactivo que proporcione información elaborada de manera inmediata al médico tratante. Ante esto último se debe garantizar que se sigan las normas éticas y de privacidad adecuadas en el uso de información médica de pacientes para evitar cualquier posible abuso o mal uso de la información.

Figura 1. Diagrama de flujo PRISMA

Alkaissi et al.(7) identifican dos áreas en las que puede ser útil en la escritura académica: la elaboración de un texto lingüísticamente coherente a partir de los pequeños puntos dispersos y la gestión y organización de referencias y citas.

Investigadores como Macdonald et al.(8) plantean que ChatGPT puede ser una gran ayuda para los investigadores en la creación de estudios, análisis y redacción de artículos científicos, pero se necesita precaución y supervisión humana en todas las etapas para garantizar la exactitud de los resultados. Advierten que su uso en la escritura de artículos científicos plantea problemas éticos, como la posible similitud en la estructura de los artículos y la cuestión de la coautoría de ChatGPT en los trabajos redactados.

Un estudio sobre las posibles aplicaciones y los límites de ChatGPT en la atención sanitaria fue desarrollado por Cascella et al.(9) Dicho estudio destacó el uso de ChatGPT en la redacción de artículos científicos, pero advierte del fenómeno de "alucinación", que se refiere a la capacidad de ChatGPT para producir respuestas que suenan creíbles pero que pueden ser incorrectas o carecer de sentido. Concluyen que investigadores y profesionales pueden utilizarlo con eficacia si tienen una comprensión clara de sus capacidades y limitaciones, evitando posibles consecuencias no deseadas.

La evaluación de texto generado por IA fue tratada por Anderson et al.(10) Si bien destaca noticias como: ChatGPT superó la sección teórica del examen de licencia médica de Estados Unidos sin formación adicional ni años de estudio de medicina,(11) ChatGPT escribe poemas y libros para niños,(12) y que Nature informó de que cuatro manuscritos en preprint acreditan a ChatGPT como autor;(13) aún se plantean problemas éticos, de equidad y de precisión. Destaca las imprecisiones de las referencias bibliográficas generadas; esto ultimo se podría deber a que la IA se nutre de trabajos donde están mal referenciados los artículos científicos.

Respecto a la autoría, Lee(14) plantea el hecho de que los chatbots de IA no son seres humanos en el sistema legal actual lo que significa que el texto no puede ser considerado como una obra protegida por derechos de autor. Lo antes expuesto implica que no puede ser considerado como autor de dicha obra la IA.

A pesar de que los chatbots de IA como ChatGPT son capaces de generar texto original, no pueden ser responsables de su escritura, lo que los coloca en el mismo nivel que un motor de búsqueda en términos de responsabilidad. Debido a esto, los chatbots de IA no pueden ser considerados autores desde la perspectiva ética de la investigación.

En consonancia con esto, Yeo-Teh et al.(14) plantea que el uso de la IA debe ser declarado de manera obligatoria y no deben figurar como autores ya que no cumplen las directrices de autoría vigentes (como los criterios de autoría ampliamente adoptados por el ICMJE).(16)

Por su parte Ali et al.(17) plantean que si bien la IA es eficiente en la escritura de cartas clínicas (dígase reportes en historias clínicas, exámenes, diagnósticos, tratamientos y recomendaciones) los resultados deben seguir siendo verificados por profesionales sanitarios.

Para poner un orden a todo lo que se avecina la revista Nature plantea reglas básicas para el uso de ChatGPT y herramientas parecidas.(18) La revista advierte que la capacidad del chatbot para generar textos precisos y confiables es motivo de preocupación para la comunidad científica. Es por ello que se recomienda reconocer el uso de la IA y la exclusión como autor acreditado en un trabajo de investigación. Si bien mediante una inspección del texto se puede reconocer errores cometidos por la IA y los frecuentes errores para citar, en el futuro los desarrolladores podrían superar estos problemas mediante la formación de chatbots en textos científicos especializados y el uso de herramientas de citación de origen.

La anterior preocupación está dada por el uso que ya le dan los usuarios de Nature a ChatGPT.(19) La revista realizó un estudio que arrojo los diferentes usos que la comunidad científica da a esta herramienta donde solo el 20,6 % de los encuestados nunca ha usado la IA (ChatGPT, GPT-3, DALL-E, MidJourney, Stable, Difusión, entre otras). Estas herramientas, declaran los encuestados, fueron usadas para:

· Diversión creativa no relacionada con mi investigación;

· Aportar ideas de investigación;

· Ayudar a escribir código;

· Ayudar a escribir presentaciones;

· Realizar revisiones bibliográficas;

· Ayudar a escribir manuscritos de investigación;

· Ayudar a crear gráficos o imágenes;

· Ayudar a redactar solicitudes de subvención;

· Dentro de motores de búsqueda científicos;

· Ayudar a redactar trabajos de curso o exámenes.

Consideraciones finales

Por todo lo antes expuesto podemos expresar que la comunidad científica puede ordenar el uso de ChatGPT en la redacción de artículos científicos estableciendo directrices éticas claras y transparentes para su uso, que incluyan la necesidad de supervisión humana en todas las etapas del proceso. Su uso debe ser regulado para evitar la sustitución de la experiencia humana y garantizar la exactitud de los resultados.

Mas allá de la aplicación de ChatGPT como herramienta para la comunidad científica, la comunidad de desarrolladores formula la idea de marcar el texto elaborado por dicha herramienta a fin de no retroalimentarse del texto por él generado sino por aquellos generados por inteligencia humana.(20,21)

Si ya GPT-3, nombre de la actual versión de ChatGPT, trajo una crisis entre investigadores, autores, editores y lectores donde nos ha costado acomodarnos, pronto GPT-4, la próxima evolución del modelo de lenguaje pre-entrenado de OpenAI, plantea nuevos desafíos. Solo adelantar que se espera que tenga una capacidad aún mayor para generar texto, resúmenes, traducciones automáticas y responder a preguntas complejas de manera coherente y precisa, incluso en comparación con los modelos anteriores de GPT. Se cree que tendrá 100 billones de parámetros, lo que es casi 600 veces más que GPT-3, y también será capaz de responder a prompts de imágenes y videos en lugar de solo trabajar con texto.(22,23)

CONCLUSIONES

La herramienta ChatGPT es útil en la escritura científica, ya que puede proporcionar comentarios y sugerencias útiles, así como ayudar en la gestión y organización de referencias y citas. Sin embargo, su uso debe ser regulado para evitar la sustitución de la experiencia humana y garantizar estándares éticos y de calidad. Aunque la IA puede ser entrenada para extraer y entender información relevante en la atención sanitaria y proporcionar recomendaciones para intervenciones médicas, se deben tener en cuenta las limitaciones y posibles consecuencias no deseadas.

Por otro lado, desde la perspectiva ética de la investigación, los chatbots de IA no pueden ser considerados autores, y su uso debe ser declarado de manera obligatoria. A pesar de que ChatGPT es capaz de generar texto original, no puede ser responsable de su escritura, lo que lo coloca en el mismo nivel que un motor de búsqueda en términos de responsabilidad. Por lo tanto, se deben adoptar las directrices de autoría vigentes para reconocer adecuadamente su uso en los trabajos de investigación.

Finalmente, la comunidad científica está utilizando cada vez más herramientas de IA como ChatGPT para diversos fines, desde la creación de manuscritos hasta la ayuda en la gestión de referencias y citas. A pesar de los posibles problemas éticos y de precisión, se debe tener precaución y supervisión humana en todas las etapas para garantizar la exactitud de los resultados y reconocer su uso en los trabajos de investigación sin atribuirles autoría.

REFERENCIAS BIBLIOGRÁFICAS

1. López Leyva S. El proceso de escritura y publicación de un artículo científico. Rev Electrónica Educ 2013;17:5-27.

2. Fernández E, García AM. Cómo escribir y publicar artículos científicos (I). Inicio del viaje: del título a los métodos. Med Paliativa 2021;28:134-9.

3. Chois-Lenis PM, Arenas-Hernández KA, Aguilar-Arias A, Mosquera-Becerra J. Apoyar la escritura del proyecto de tesis en salud. Magis Rev Int Investig En Educ 2020;12:39-58. https://doi.org/10.11144/Javeriana.m12-25.aept.

4. Castillo-González W. ChatGPT and the future of scientific communication. Metaverse Basic Appl Res Internet 2022;1:8. https://doi.org/10.56294/mr20228.

5. Carrasco JP, García E, Sánchez DA, Porter E, De-La-Puente L, Navarro J, et al. ¿Es capaz “ChatGPT” de aprobar el examen MIR de 2022? Implicaciones de la inteligencia artificial en la educación médica en España. Rev Esp Educ Médica 2023;4:55-69. https://doi.org/10.6018/edumed.556511.

6. Salvagno M, Taccone FS, Gerli AG. Can artificial intelligence help for scientific writing? Crit Care Lond Engl 2023;27:75. https://doi.org/10.1186/s13054-023-04380-2.

7. Alkaissi H, McFarlane SI. Artificial Hallucinations in ChatGPT: Implications in Scientific Writing. Cureus 2023;15:e35179. https://doi.org/10.7759/cureus.35179.

8. Macdonald C, Adeloye D, Sheikh A, Rudan I. Can ChatGPT draft a research article? An example of population-level vaccine effectiveness analysis. J Glob Health 2023;13:01003. https://doi.org/10.7189/jogh.13.01003.

9. Cascella M, Montomoli J, Bellini V, Bignami E. Evaluating the Feasibility of ChatGPT in Healthcare: An Analysis of Multiple Clinical and Research Scenarios. J Med Syst 2023;47:33. https://doi.org/10.1007/s10916-023-01925-4.

10. Anderson N, Belavy DL, Perle SM, Hendricks S, Hespanhol L, Verhagen E, et al. AI did not write this manuscript, or did it? Can we trick the AI text detector into generated texts? The potential future of ChatGPT and AI in Sports & Exercise Medicine manuscript generation. BMJ Open Sport Exerc Med 2023;9:e001568. https://doi.org/10.1136/bmjsem-2023-001568.

11. DePeau- Wilson M. AI passes U.S. Medical Licensing Exam 2023. https://www.medpagetoday.com/special-reports/exclusives/102705.

12. Nolan B. This man used AI to write and illustrate a children’s book in one weekend. he wasn’t prepared for the backlash. 2023. https://www.businessinsider.com/chatgpt-midjourney-ai-write-illustrate-childrens-book-one-weekend-alice-2023-1?utm_campaign=sf-insider-main&utm_medium=social&utm_source=facebook.com&fbclid=IwAR2kBmnWWvc6kF8jIALl61kVA2FNWExrPSCOgUfdri-ovBDa2wMsNj8L4GU&mibextid=Zxz2cZ.

13. Stokel-Walker C. ChatGPT listed as author on research papers: many scientists disapprove. Nature 2023;613:620-1. https://doi.org/10.1038/d41586-023-00107-z.

14. Lee JY. Can an artificial intelligence chatbot be the author of a scholarly article? J Educ Eval Health Prof 2023;20. https://doi.org/10.3352/jeehp.2022.20.6.

15. Yeo-Teh NSL, Tang BL. Letter to editor: NLP systems such as ChatGPT cannot be listed as an author because these cannot fulfill widely adopted authorship criteria. Acc Res 2023;13:1-3. https://doi.org/10.1080/08989621.2023.2177160.

16. International Committee of Medical Journal Editors. Recommendations for the Conduct, Reporting, Editing, and Publication of Scholarly Work in Medical Journals 2022.

17. Ali SR, Dobbs TD, Hutchings HA, Whitaker IS. Using ChatGPT to write patient clinic letters. Lancet Digit Health 2023;S2589-7500(23)00048-1:1-3. https://doi.org/10.1016/S2589-7500(23)00048-1.

18. Tools such as ChatGPT threaten transparent science; here are our ground rules for their use. Nature 2023;613:612. https://doi.org/10.1038/d41586-023-00191-1.

19. Owens B. How Nature readers are using ChatGPT. Nature 2023;615(7950):20. https://doi.org/10.1038/d41586-023-00500-8.

20. Ramírez M. La IA se revuelve contra sí misma: una herramienta ya detecta textos generados por IA. El Esp 2023. https://www.elespanol.com/elandroidelibre/noticias-y-novedades/20230201/ia-revuelve-misma-herramienta-detecta-textos-generados/738176205_0.html.

21. Bécares B. OpenAI crea una solución para detectar textos con ChatGPT y otras IA pensando en los educadores: es gratis y así funciona. GENBETA 2023. https://www.genbeta.com/actualidad/openai-crea-solucion-para-detectar-textos-chatgpt-otras-ia-pensando-educadores-gratis-asi-funciona.

22. Márquez J. GPT-4: cuándo se lanzará la IA más avanzada de OpenAI, cómo funcionará y todas las novedades. XATAKA 2023. https://www.xataka.com/nuevo/gpt-4-que-cuando-sale-como-funciona-toda-informacion.

23. Pastor J. GPT-4 llegará la semana que viene según Microsoft. Y su gran novedad es que será «multimodal». XACATA 2023. https://www.xataka.com/robotica-e-ia/gpt-4-llegara-semana-que-viene-microsoft-su-gran-novedad-que-sera-multimodal.

FINANCIACIÓN

Ninguna.

CONFLICTO DE INTERESES

Ninguna.

CONTRIBUCIÓN DE AUTORÍA

Conceptualización: William Castillo-González.

Investigación: William Castillo-González.

Metodología: William Castillo-González.

Análisis formal: William Castillo-González.

Investigación: William Castillo-González.

Redacción - Borrador original: William Castillo-González.

Redacción - Revisión y edición: William Castillo-González.